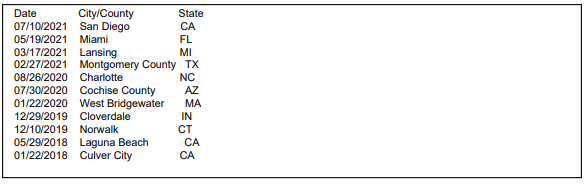

Dal 2018 a oggi ci sono stati almeno 11 incidenti da un’auto Tesla e dei veicoli di pronto intervento e, in tutti questi casi, l’Autopilot era acceso, per questo motivo la National Highway Traffic Safety Administration (NHTSA), un’ente americano che si occupa di sicurezza stradale, ha dovuto aprire un’indagine per assicurarsi che la Tesla si preoccupi di monitorare e far rispettare l’attenzione del conducente in qualsiasi caso. Gli incidenti hanno causato un morto e 17 feriti, gran parte di questi dopo il tramonto e in diversi Stati, dalla California alla Florida, dal Michigan al Texas.

Fonte: Twitter @LBPD_PIO_45

Questa non è la prima volta che la NHTSA decide di indagare sull’autopilota di Tesla. La prima volta è stata cinque anni fa, nel 2016, quando c’è stato un incidente mortale che poi ha portato ad altri 30 incidenti collegati ad Autopilot. Tuttavia, la questione si concluse in un semplice gossip. Adesso però ci sono altri 11 incidenti in cui sembra essere coinvolto l’autopilota, il cui più recente è del mese scorso. In più, a giugno la NHTSA aveva annunciato che avrebbe chiesto a tutti i produttori di auto con guida automatizzata di comunicare entro un giorno degli eventuali incidenti.

L’autopilota è un sistema di assistenza alla guida di Tesla che continua a mantenere la stessa velocità tenendoli anche centrati nelle corsie mentre il conducente non può, sebbene, comunque, dovrebbe sempre supervisionare il lavoro del pilota automatico. La Tesla è stata criticata per diversi anni proprio per questo motivo: l’autopilota fa pensare che il pilota possa distrarsi e far quel che vuole, ma in realtà non è così. Sotto accusa, al momento, è proprio l’autopilota, sebbene comunque la gran parte della colpa vada al conducente.

«Siamo lieti che NHTSA finalmente abbia ascoltato la nostra richiesta di lunga data per indagare Tesla per mettere la tecnologia sulla strada che è utilizzata in modo che da causare incidenti, feriti e morti. Questa indagine deve andare ben oltre gli incidenti che coinvolgono i veicoli di primo soccorso, perché il pericolo è per tutti i conducenti, passeggeri e pedoni quando il pilota automatico è agganciato», ha detto Jason Levin, direttore esecutivo del Centro per la Sicurezza Auto.

Jake Fisher, direttore di auto test a Consumer Reports, ha invece detto che «NHTSA, senza mezzi termini, ha bisogno di capire cosa sta succedendo e fare qualcosa per aiutare a prevenire questi tipi di incidenti, non solo nella Tesla, ma in altri veicoli che utilizzano questa tecnologia. Un modo più pesante per assicurare che il conducente stia guardando la strada è l’unico modo che abbiamo per tenere le persone al sicuro. Per un sacco di persone, Autopilota significa che l’auto è auto-guida. Ma indipendentemente da come lo chiamano, l’esperienza al volante porta a un’eccessiva fiducia».

This morning a Tesla sedan driving outbound Laguna Canyon Road in “autopilot” collides with a parked @LagunaBeachPD unit. Officer was not in the unit at the time of the crash and minor injuries were sustained to the Tesla driver. #lagunabeach #police #tesla pic.twitter.com/7sAs8VgVQ3

— Laguna Beach PD PIO (@LBPD_PIO_45) May 29, 2018

NHTSA: il documento sull’indagine sull’autopilota di Tesla

La NHTSA ha rilasciato il documento in cui spiegano perché stanno indagando sul sistema di Autopilota di Tesla. In primis viene sottolineato che gli incidenti sono 11, con 17 feriti e un morto. Spiegano poi che «da gennaio 2018, l’Ufficio Indagini Difetti (ODI) ha individuato undici incidenti in cui i veicoli Tesla di varie configurazioni si scontrati con veicoli di primo soccorso. La maggior parte degli incidenti ha avuto luogo dopo il tramonto e le scene dell’incidente includevano misure di controllo della scena come luci di primo soccorso, frecce illuminate e coni stradali». Tutti i veicolari stavano utilizzando l’Autopilota o il Traffic Aware Cruise Control.

Viene poi spiegato che l’«Autopilot è un sistema avanzato di assistenza alla guida (Advanced Driver Assistance System, ADAS) in cui il veicolo mantiene la sua velocità e centraggio della corsia quando è impegnato all’interno del suo Operational Design Domain (ODD). Con l’ADAS attivo, il conducente ha ancora la responsabilità primaria per il rilevamento e la risposta di oggetti e eventi (OEDR), ad esempio l’identificazione degli ostacoli nella carreggiata o manovre avverse da parte di veicoli vicini durante il Dynamic Driving Task (DDT).»

Infine, si spiega che l’ODI ha deciso di aprire una «valutazione preliminare del sistema ADAS di livello 2 SAE (Autopilot) del modello anno 2014-2021, modelli Y, X, S e 3». L’obiettivo è quello di valutare «le tecnologie e i metodi utilizzati per monitorare, assistere e far rispettare l’impegno del conducente con la funzione di guida dinamica durante il funzionamento del pilota automatico.» Infine, «L’indagine valuterà inoltre l’OEDR da parte dei veicoli in modalità Autopilota e ODD in cui la modalità Autopilota è funzionale. L’indagine comprenderà anche l’esame delle circostanze che hanno contribuito agli incidenti confermati elencati di seguito e ad altri incidenti simili».

NEW: @ntsb chair @JenniferHomendy on @NHTSAgov @Tesla probe pic.twitter.com/KbwsvKgLSo

— davidshepardson (@davidshepardson) August 16, 2021

Giulia, 25 anni, laureata in Lettere Classiche, “paladina delle cause perse” e studentessa di Filologia Italiana. Amo scrivere, leggere, guardare serie tv e anime, i gatti e seguire le giuste polemiche.

Instagram: @murderskitty